Metody przetwarzania

i analizy danych

Klasyfikacja

© Łukasz Wawrowski

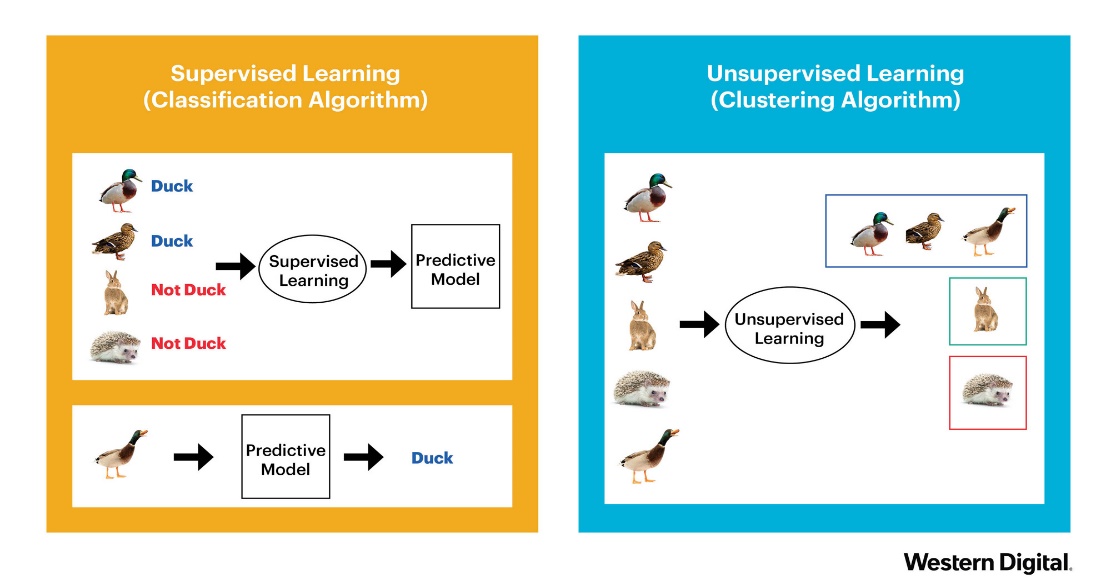

Podział metod

Uczenie nadzorowane - końcowy wynik jest znany

klasyfikacja

regresja

Uczenie nienadzorowane - końcowy wynik nie jest znany

grupowanie obiektów

grupowanie cech

Podział metod

Klasyfikacja

dane tabelaryczne

obrazy

teksty

Klasyfikacja

binarna (binary) - tylko dwa warianty: zachorowanie, spłata kredytu

wieloklasowa (multiclass) - typ klienta

wieloetykietowa (multilabel) - gatunek filmu

A visual introduction to machine learning

Model Tuning and the Bias-Variance Tradeoff

Przykład

- Age (numeric)

- Sex (text: male, female)

- Job (numeric: 0 - unskilled and non-resident, 1 - unskilled and resident, 2 - skilled, 3 - highly skilled)

- Housing (text: own, rent, or free)

- Saving accounts (text - little, moderate, quite rich, rich)

- Checking account (text, little, moderate, rich)

- Credit amount (numeric, in DM)

- Duration (numeric, in month)

- Purpose (text: car, furniture/equipment, radio/TV, domestic appliances.. and so on...)

- Risk (text: good/bad): it's our Target Variable, describes if client paid or didn't pay loan

Zadanie

Proszę utworzyć nową zmienną o nazwie installment, która będzie zawierała wysokość raty.

05:00

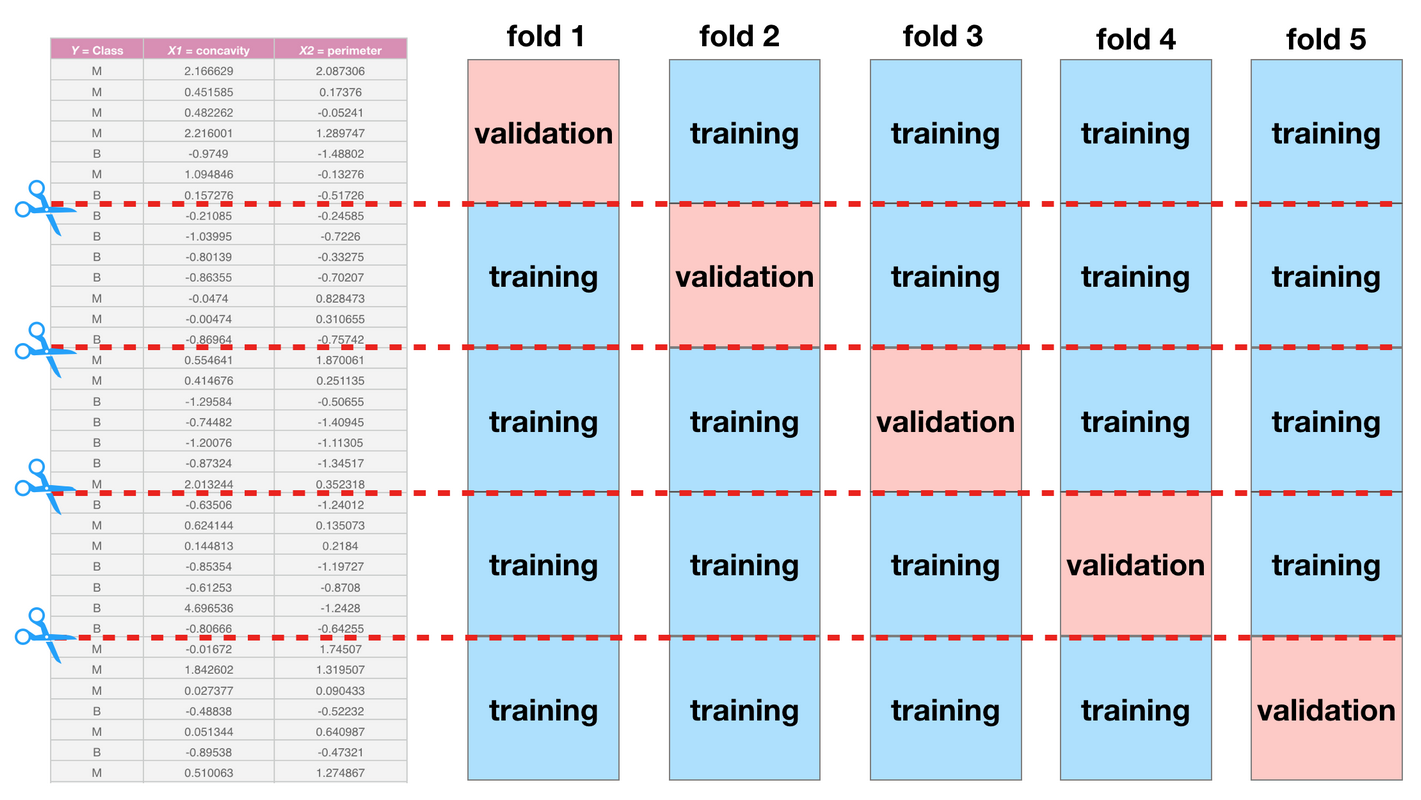

Podział danych

dane uczące (treningowe) - zbiór przykładów używanych do dopasowania parametrów algorytmu

dane testowe - niezależny od danych uczących zbiór przykładów o takim samym rozkładzie jak dane uczące

dane walidacyjne - zbiór przykładów używanych do dopasowania hiperparametrów

Często nazewnictwo danych testowych i walidacyjnych jest mylone.

Pakiet rsample zawiera funkcje do podziału zbiorów.

Algorytmy

white-box: regresja logistyczna, drzewa decyzyjne

black-box: sieci neuronowe, XGBoost

Niektóre z metod opierają się na losowości i wyniki mogą się wtedy nieznacznie różnić pomiędzy uruchomieniami. Aby tego uniknąć można zastosować ziarno generatora set.seed().

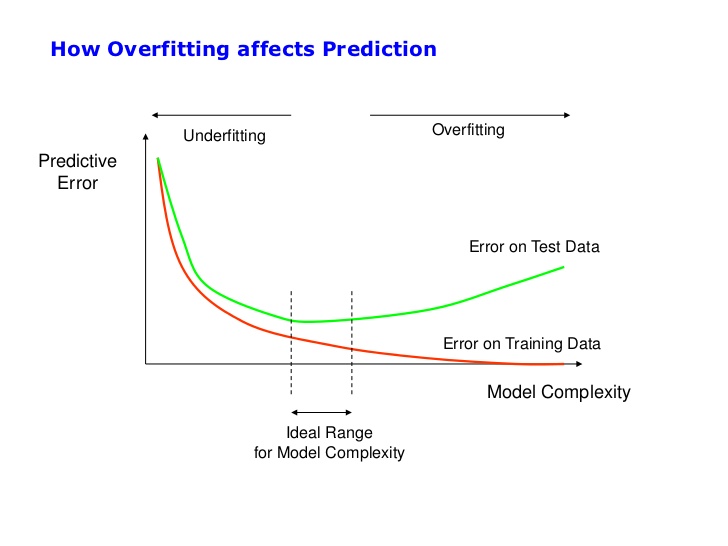

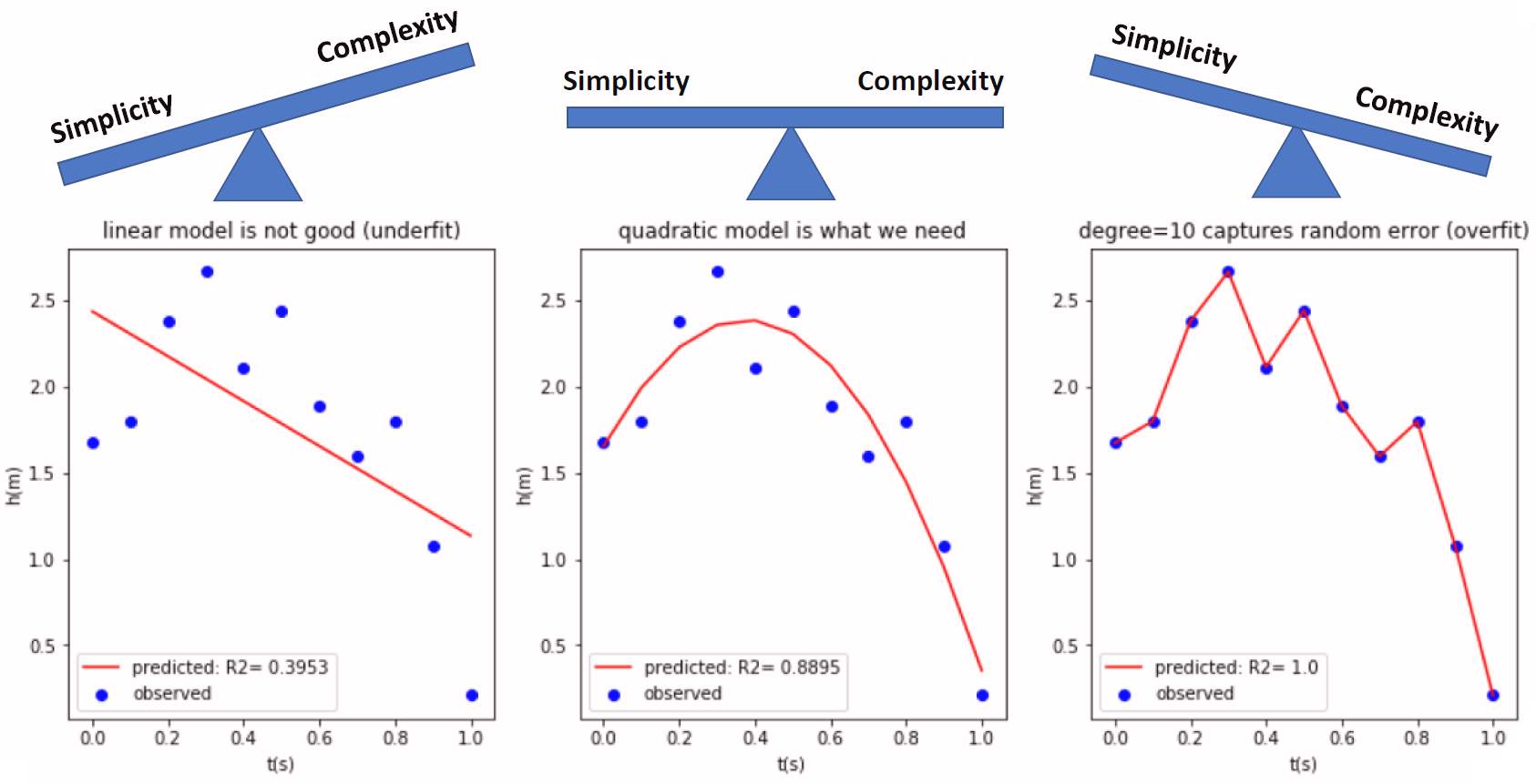

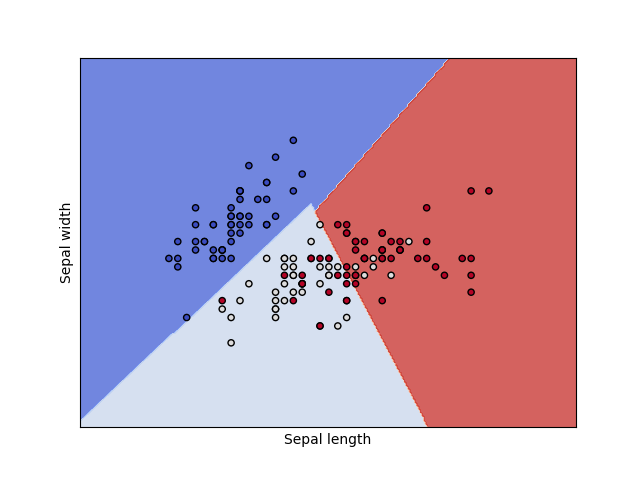

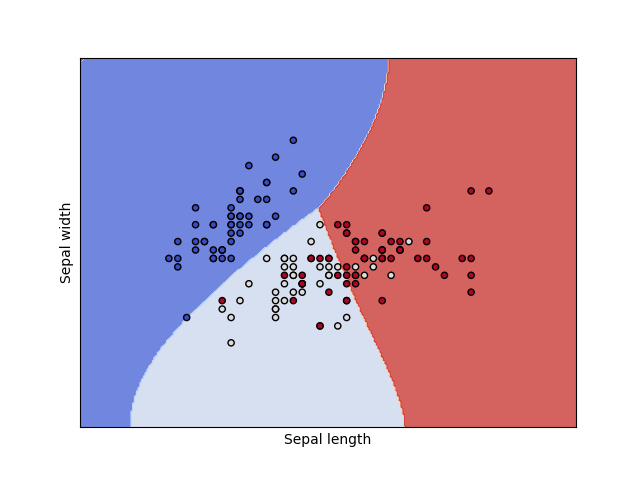

Złożoność modelu

Złożoność modelu

Frameworki do ML

Istnieje wiele pakietów implementujących różne algorytmy ML (sprawdź na Machine Learning Task View). Można korzystać z nich pojedynczo, ale nie są w żadnej sposób wystandaryzowane: różne nazwy argumentów i struktury obiektów wynikowych.

Pakiety mające na celu integrację różnych algorytmów:

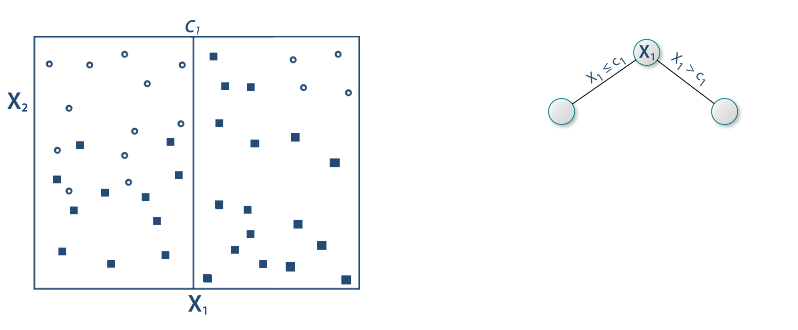

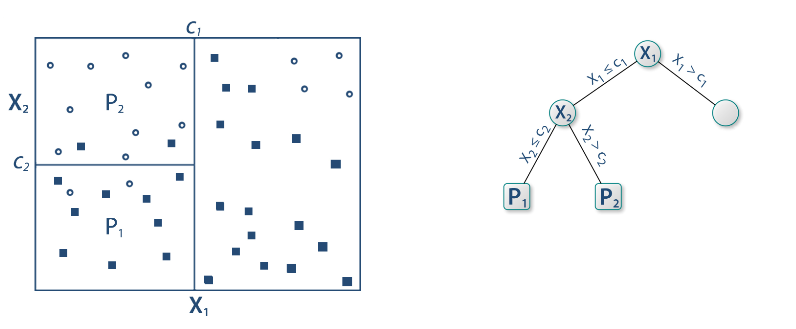

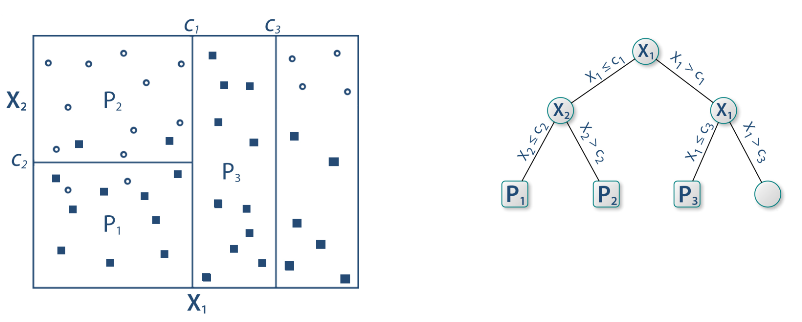

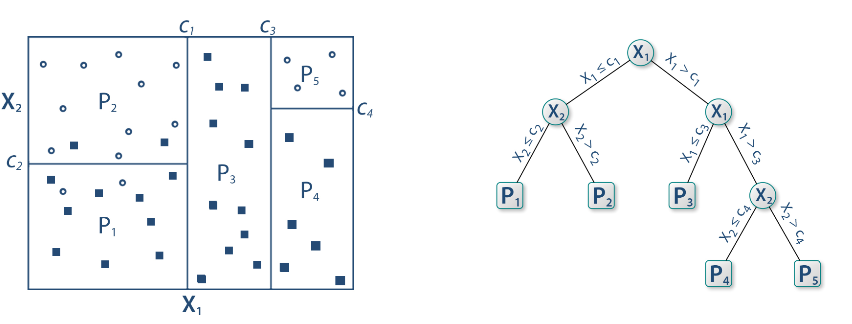

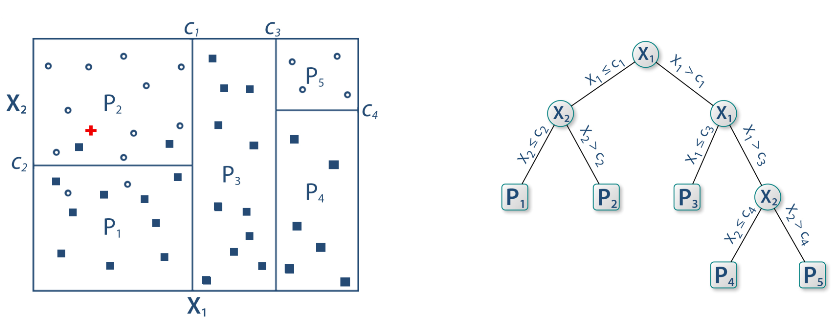

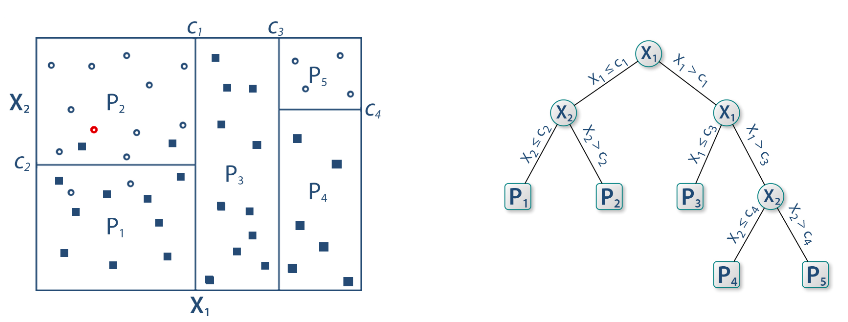

Drzewa decyzyjne

Drzewa decyzyjne

Drzewa decyzyjne

Drzewa decyzyjne

Drzewa decyzyjne

Drzewa decyzyjne

Pakiet rpart

Pakiet rpart umożliwia tworzenie prostych drzew decyzyjnych. Do wizualizacji tychże najlepiej wykorzystać pakiet rpart.plot, który tworzy drzewa bardziej atrakcyjne wizualnie.

W przypadku klasyfikacji binarnej każdy węzeł prezentuje:

prognozowaną klasę

prawdopodobieństwa zaklasyfikowania do klasy pozytywnej

odsetek obserwacji w węźle

Pakiet caret zawiera wiele funkcji przydatnych w klasyfikacji.

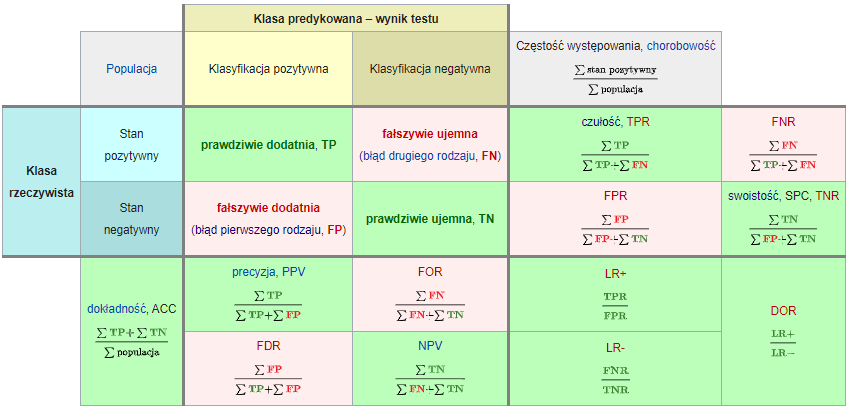

Miary

Wyniki klasyfikacji można oceniać za pomocą wielu miar:

Dokładność (accuracy): % poprawnie zaklasyfikowanych

Precyzja (precison): % poprawnie rozpoznanych przypadków pozytywnych TP/(TP+FP)

Czułość (sensitivity/recall): % prawdziwie pozytywnych TP/(TP+FN)

Swoistość (specificity): % prawdziwie negatywnych TN/(TN+FP)

F1: średnia harmoniczna z czułości i precyzji 2TP/(2TP+FP+FN)

SVM - maszyna wektorów nośnych

SVM - maszyna wektorów nośnych

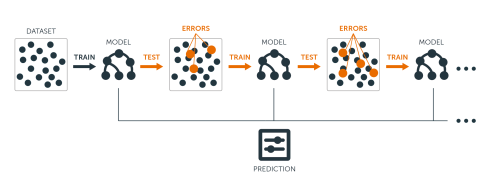

Lasy losowe

- Weź zbiór danych

- Wybierz \(n\) drzew do zbudowania

- Dla wartości od \(i = 1\) do \(n\):

- | Wylosuj próbę bootstrapową

- | Stwórz drzewo na podstawie wylosowanych danych

- | Dla każdego podziału

- | | Wylosuj \(m\) zmiennych ze wszystkich \(p\) zmiennych

- | | Wybierz najlepszą zmienną do podziału

- | | Stwórz podział

- | Zakończ proces budowy drzewa kiedy kryterium jest optymalne

- Zwróć zbiór wynikowych drzew

Pakiet ranger zawiera szybką implementację lasów losowych.

Boosting gradientowy

Pakiet h2o

H2O is an open source, in-memory, distributed, fast, and scalable machine learning and predictive analytics platform that allows you to build machine learning models on big data and provides easy productionalization of those models in an enterprise environment.

wiele algorytmów

wbudowane metody Explainable AI (XAI) (patrz też: DrWhy)

interfejs graficzny

h2o.flow()automatyczny dobór modelu

h2o.automl()- webinar

Tuning hiperparametrów

Domyślne parametry modelu nie muszą dawać najlepszych rezultatów. W celu ulepszenia klasyfikatora stosuje się metody przeszukiwania parametrów.

learning rate

max depth

number of trees

sample rate

Można przeszukiwać całą przestrzeń parametrów (intensywne obliczeniowo) albo losowo.

Kod w h2o

gbm_params <- list(learn_rate = seq(0.01, 0.1, 0.01), max_depth = seq(2, 10, 1), sample_rate = seq(0.5, 1.0, 0.1), col_sample_rate = seq(0.1, 1.0, 0.1), ntrees = seq(50,150,10))search_criteria <- list(strategy = "RandomDiscrete", max_models = 36, seed = 1)gbm_grid <- h2o.grid(algorithm = "gbm", x = x_var, y = y_var, grid_id = "gbm_grid1", training_frame = train_data_h2o, validation_frame = test_data_h2o, seed = 1, hyper_params = gbm_params, search_criteria = search_criteria)gbm_gridperf <- h2o.getGrid(grid_id = "gbm_grid", sort_by = "auc", decreasing = TRUE)m4 <- h2o.getModel(gbm_gridperf@model_ids[[1]])Symulacja wyniku biznesowego

średnia kwota kredytu: 3500

marża na spłaconym kredycie: 20%

strata na niespłaconym kredycie: 50%

$$\text{wynik}=\text{TP}\cdot(3500\cdot0,2)-\text{FP}\cdot(3500\cdot0,5)$$

Krzywa ROC

Krzywa ROC to jeden ze sposobów wizualizacji jakości klasyfikacji, pokazujący zależności wskaźników TPR (True Positive Rate) oraz FPR (False Positive Rate).

obliczamy prawdopodobieństwo klasyfikacji do danej klasy

testujemy wiele progów prawdopodobieństwa (domyślnie 0,5)

dla każdego progu obliczamy macierz pomyłek

Pole pod krzywą ROC - AUC (Area under curve) jest jedną z miar jakości klasyfikacji. AUC = 1 (klasyfikator idealny), AUC = 0.5 (klasyfikator losowy), AUC < 0.5 (klasyfikator gorszy od losowego).

Objaśnianie modelu

Ważność cech - jak bardzo model wykorzystuje daną cechę do predycji.

Partial dependency plots - jak zmienia się prawdopodobieństwo klasyfikacji w zależności od predyktora.

Interpretable Machine Learning

Zadanie

Przeprowadź klasyfikację mieszkań ze względu na miejsce.

homes <- read_csv("http://www.wawrowski.edu.pl/data/sf_ny_homes.csv")homes <- homes %>% mutate(in_sf=as.factor(in_sf))